ChatGPT no reemplazará la búsqueda de Google (todavía)

Incluso en medio de las incesantes noticias y acontecimientos de principios de 2023, es probable que hayas oído hablar de ChatGPT, el chatbot GPT-3 (técnicamente, 3.5), que es sorprendentemente capaz de simular respuestas humanas. Si te interesa todo lo relacionado al posicionamiento en buscadores, veamos lo que el especialista de Moz, Peter J. Meyers, tiene para contarnos sobre esta herramienta.

Considera, por ejemplo, la siguiente pregunta y respuesta (creada por GPT-3):

- ¿ChatGPT es un motor de búsqueda?

No, ChatGPT no es un motor de búsqueda. Es un chatbot basado en inteligencia artificial que utiliza el procesamiento del lenguaje natural para entender y responder a los usuarios.

Eso no está mal, y suena como lo que un humano respondería.

GPT (Generative Pre-training Transformer) es un sistema de aprendizaje profundo que genera texto basado en la predicción de patrones de lenguaje después de haber sido entrenado con un gran conjunto de documentos.

Para el siguiente artículo, usaré el Playground de OpenAI con el modelo GPT-3 «text-davinci-003», que se puede programar para producir respuestas más cortas y es más confiable que el ChatGPT Beta.

Los modelos actuales son realmente impresionantes, incluyendo el análisis de preguntas complejas:

- ¿Cómo explicarías ChatGPT a un niño de 5 años?

ChatGPT es como un amigo robot que puede hablar contigo y responder tus preguntas. Es como tener un amigo que sabe mucho sobre diferentes cosas y puede ayudarte a aprender nuevas.

GPT puede, incluso, imitar la creatividad humana y hacernos cuestionar nuestros propios talentos:

- Escribe un eslogan para un restaurante con temática de Marte dirigido por personas lagarto, al estilo de Edgar Allen Poe.

“Lagartos de Marte, cenen aquí en esplendor, ¡donde los sueños se despliegan y los paladares se derriten!”

A estas alturas, ya has visto probablemente muchos ejemplos, entonces, ¿qué tiene que ver todo esto con la búsqueda de Google y nuestro trabajo como profesionales del marketing?

Te puede interesar: 10 razones por las que necesitas una estrategia de contenidos a largo plazo

Google y la era del lenguaje natural

En los primeros días de búsqueda, los motores de búsqueda se construyeron para indexar palabras y frases cortas y no tenían capacidad para procesar el lenguaje natural. Si querías buscar una nueva laptop, podías escribir frases como «laptop» o «comprar laptop”.

A veces bromeo con que si entras a Best Buy y empiezas a gritar «¡laptop!», probablemente te escoltaría la seguridad. Sin embargo, nosotros los humanos nos adaptamos a la búsqueda precoz y simplificamos nuestro lenguaje.

A medida que la búsqueda se hizo más sofisticada, aprendimos que podíamos realizar consultas más complejas y, sobre todo con la llegada de la búsqueda por voz, experimentamos con algo más cercano al lenguaje natural.

A medida que Google se adaptó, algo interesante sucedió: nuestras consultas se convirtieron en preguntas, incitando a Google a darse cuenta de que a veces no queremos un enlace a un recurso, sino una respuesta.

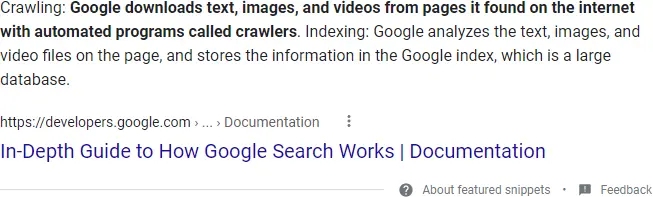

Google ha evolucionado mucho como un «motor de respuestas”, incluyendo la creación del Knowledge Graph (gráfico de conocimiento) y la entrega de resultados web como respuestas directas conocidas como Fragmentos destacados. Por ejemplo, si buscas «¿Cómo funciona la búsqueda de Google?», podrías toparte con un Fragmento destacado (básicamente, una respuesta atribuida) como esta:

Este ejemplo, en particular, no es del todo adecuado, pero ilustra cómo funciona el algoritmo. Google busca partes y fragmentos de documentos que podrían responder a la pregunta. En este caso, es obvio que el pasaje extraído no es realmente una respuesta completa.

Ahora, hagámosle la misma pregunta a GPT-3:

- ¿Cómo funciona la búsqueda de Google?

La búsqueda de Google funciona rastreando la web e indexando sitios web. Cuando un usuario busca algo, Google revisa su índice y arroja los resultados más relevantes. Utiliza una combinación de algoritmos y otras técnicas para determinar la relevancia de los resultados. Estos algoritmos tienen en cuenta factores como las palabras utilizadas en la consulta, la actualidad del contenido, la popularidad del sitio web y la ubicación del usuario.

Puedo criticar esta respuesta, pero en general, es bastante buena y es mucho más completa que un extracto de un sitio web. El motor GPT-3 ha resumido esencialmente varias fuentes.

Es fácil ver cómo esto podría empezar a poner nervioso a Google.

La confianza y el problema de la atribución

A primera vista, GPT-3 (y sobre todo ChatGPT) puede brindar algunas respuestas bastante humanas. No obstante, sin contar preguntas éticas (tales como, el plagio y el sesgo), hay algunos problemas prácticos graves.

La «respuesta» de Google tiene una gran ventaja: la atribución. Podemos ir fácilmente a la página de origen. Esto no solo nos proporciona más información, sino que brinda más contexto, incluyendo detalles sobre la propia fuente. Esos detalles pueden ayudarnos a confiar (o, en algunos casos, desconfiar) en la respuesta.

Por ejemplo, observa otra respuesta de GPT-3 a la pregunta anterior:

- ¿Cómo funciona la búsqueda de Google?

Google Search funciona mediante el uso de una combinación de algoritmos y programas para analizar el contenido de las páginas web y otro contenido en línea para determinar su relevancia para la consulta de búsqueda de un usuario. Los algoritmos de búsqueda de Google buscan una variedad de factores, incluyendo la densidad de palabras clave, la actualidad y la cantidad de otros sitios que enlazan a la página. Google también utiliza la inteligencia artificial y el aprendizaje automático para mejorar sus resultados de búsqueda.

Esta respuesta también suena creíble, excepto que la mayoría de los profesionales en SEO se estremecerían ante la mención de la densidad de palabras clave, ampliamente considerada un mito. Es muy posible que esta información provino de una fuente completamente diferente, pero sin atribución, no podemos validarlo.

Si bien este es un problema complejo (el texto generado automáticamente no utiliza fuentes de la misma manera que un ser humano, o podría utilizar docenas o cientos de fuentes), enfoques híbridos que reducen el número de fuentes y proporcionan atribución son posibles.

Considera esta respuesta de Neeva, un motor de búsqueda alternativo enfocado en la privacidad, para “¿Debería pedir un latte tall o grande?”:

“Según los resultados, el tamaño grande es mejor que el tamaño tall, ya que contiene más onzas líquidas a un precio similar. Además, el tamaño grande contiene más cafeína que el tamaño tall, lo que resulta una mejor opción para aquellos que buscan un toque más fuerte de cafeína. Asimismo, pedir una bebida de tamaño grande en un vaso de tamaño venti puede ser una forma rentable de obtener más por tu dinero. Por eso, al parecer, el tamaño grande es la mejor opción para aquellos que buscan un toque más fuerte de cafeína y más valor por su dinero”.

Si bien esta funcionalidad está en beta y obviamente no funciona a escala de Google, Neeva intenta proporcionar fuentes primarias. Elegí a propósito un ejemplo ridículo porque hay poco en juego. Imagina una pregunta directamente en lo que Google llama el ámbito YMYL (tu dinero, tu vida), como: “¿Es mejor Bitcoin o Dogecoin?”:

“Al parecer, Dogecoin es una mejor opción de inversión que Bitcoin en 2022 debido a su potencial de retornos significativos en el futuro y a sus transacciones más rápidas y baratas. Sin embargo, Bitcoin es más sólida y segura para la inversión a largo plazo”.

Esta es una pregunta que podría afectar seriamente mi futuro financiero y saber de dónde viene la respuesta hace una gran diferencia y me permite profundizar y confiar o rechazar esas fuentes.

Relacionada a la confianza, hay una cuestión ética más profunda de si el texto generado automáticamente es una forma de plagio. Si bien el plagio tradicional generalmente consiste en copiar de manera intencional fragmentos de texto considerables, el texto generado por máquina aún se genera a espaldas de escritores y creadores de contenidos sin ninguna atribución clara, al menos en el caso de ChatGPT.

En el caso de Google, el uso excesivo de texto generado por máquina podría desalentar a los creadores de contenido y hacernos cuestionar si queremos contribuir con nuestros esfuerzos a “la máquina” de otra persona.

Alucinaciones y sueños de máquina

Sin restricciones cuidadosas, los sistemas de aprendizaje automático son propensos a las alucinaciones. En el caso de ChatGPT, eso básicamente significa que el sistema puede generar respuestas que no están arraigadas en la realidad. En pocas palabras, ChatGPT no entiende nada de lo que dice, solo crea nuevos patrones según el lenguaje humano. Observa esta pregunta sin sentido que le hice a GPT-3:

- ¿De qué trata el éxito de Mozart de 1976 «The Fast and the Furious: Tokyo Drift»?

El éxito de Mozart en 1976 «The Fast and the Furious: Tokyo Drift» no está relacionado con la película de 2006 del mismo nombre. Es una pieza instrumental que captura la energía frenética de las calles de Tokio por la noche. La canción se basa en una línea de piano sincopada y pegadiza y un ritmo alegre.

Aunque intrigante, no existe dicha pieza instrumental. He hecho una pregunta sin sentido y GPT-3 me ha dado una respuesta sin sentido.

Debo señalar que ChatGPT ya tiene algunas limitaciones incorporadas que tratan problemas como estos. Y modelos complejos (incluyendo la interfaz GPT-3 de OpenAI) te permiten controlar la «aleatoriedad» (alta aleatoriedad = menos restricciones), pero el problema central es desafiante.

Ahora, veamos una pregunta financiera de mayor riesgo:

- ¿Qué es más popular: Dogecoin, Bassetcoin, o Norwegianlundehundcoin?

Dogecoin es de lejos la moneda más popular de las tres, con una capitalización bursátil actual de más de 9000 millones de dólares. Bassetcoin y Norwegianlundehundcoin son monedas mucho más pequeñas con límites de mercado de solo unos pocos cientos de miles de dólares cada una.

Un límite de mercado de unos pocos cientos de miles de dólares cada una es bastante impresionante para dos criptomonedas que (hasta este momento) no existen. Lamento decir que empecé este ejemplo con Labradoodlecoin, solo para descubrir que Labradoodlecoin realmente existe.

El texto moderno generado por máquina es mucho menos propenso a alucinaciones que las iteraciones anteriores. Por ello, cada vez que combines múltiples fuentes sin tener en cuenta su veracidad o integridad, hay un riesgo real de que el resultado final sea una tontería verosímil.

Te puede interesar: 4 maneras de utilizar el marketing de contenidos para hacer crecer tu marca personal

Escala e internet en tiempo real

Esto es bastante sencillo: Lo que funciona a escala beta puede no funcionar a escala de Google. Como señalaría el difunto Bill Slawski, solo porque Google tiene una idea, o incluso patenta una idea, no significa que implementen esa idea en la búsqueda (por muchas razones).

Otro problema es la velocidad de internet. ChatGPT está entrenado en un corpus estático, un momento en el tiempo. Google rastrea e indexa internet muy rápidamente y puede entregar información reciente, localizada e incluso personalizada.

Vale la pena señalar que Google ha invertido grandes cantidades de dinero en el aprendizaje automático. LaMDA (Language Model for Dialogue Applications) de Google es capaz de generar texto complejo y humano. Asimismo, Google es muy consciente de las limitaciones y los costos de estos modelos. Si se han movido lentamente en su despliegue a través de la búsqueda, probablemente existen buenas razones.

Si bien el tema del sesgo va mucho más allá del alcance de este artículo, la escala también contribuye al problema del sesgo. Una vez que pasas de un corpus estático y controlado y abres modelos de aprendizaje automático a todo el mundo del contenido en tiempo real, prejuicios humanos se asoman rápidamente (incluyendo el racismo, el sexismo, la homofobia, y otros sesgos destructivos). A escala de Google, reducir el sesgo es un problema que requiere mucha intervención humana y recursos.

Código rojo y amenazas futuras

Nada de esto es para sugerir que Google no tome en serio a GPT (incluyendo ChatGPT). Según informes, Google emitió un «código rojo» después de que ChatGPT se volviera viral. Si bien es comprensible que Google guarde silencio sobre sus reacciones internas, es casi seguro que los acontecimientos recientes están acelerando los debates y los desarrollos en Mountain View.

Otra clara amenaza es que Microsoft es un inversor (por un valor de $1 mil millones) en OpenAI (y, con ello, ChatGPT), y circulan rumores de que pueden invertir miles de millones más. Microsoft también ha anunciado que comenzará a integrar ChatGPT en la búsqueda de Bing para fines de marzo, aunque no está claro lo que se requerirá a partir de ese lanzamiento inicial.

Uno de los mayores impactos a largo plazo de modelos como ChatGPT y LaMDA será en la búsqueda conversacional (incluyendo, entre otros, la búsqueda por voz). Observa la siguiente “conversación” que tuve con ChatGPT:

- ¿Cuáles son las cinco mejores SUV de tres filas?

Es difícil decir cuáles son las cinco mejores SUV de tres filas, ya que puede ser subjetivo y depender de factores como la preferencia personal, el presupuesto y la ubicación. Sin embargo, algunas SUV de tres filas que a menudo se consideran entre las mejores de su clase incluyen:

– Honda Pilot

– Toyota Highlander

– Kia Telluride

– Hyundai Palisade

– Subaru Ascent

- ¿Cuál de ellas es la menos cara?

De las cinco SUV que mencioné, la Subaru Ascent tiende a ser la menos costosa con un precio inicial de alrededor de $32,295. Las otras SUV que mencioné tienen un precio inicial de alrededor de $32,000 a $38,000. Sin embargo, es importante tener en cuenta que el precio final puede variar dependiendo del nivel de acabados específicos y las opciones que se elijan.

- ¿La Subaru se considera fiable?

Por lo general, Subaru se considera un fabricante de automóviles fiable, ya que muchos de sus vehículos reciben altas calificaciones por confiabilidad. La Subaru Ascent, en particular, tiene una reputación de ser un vehículo confiable con un interior cómodo y buen ahorro de combustible. Según Consumer Reports, la Ascent obtiene una puntuación de fiabilidad superior a la media.

Lo sentimos, ChatGPT definitivamente puede volverse conversador (y esta es la versión editada). Observa las preguntas de seguimiento y cómo no tuve que repetir la información o proporcionar el contexto. ChatGPT entendió que me estaba basando en respuestas anteriores.

Si bien este modelo no servirá para todos los casos de uso de búsqueda, definitivamente hay situaciones en las que la capacidad de refinar una consulta de forma fácil y conversacional podría ser revolucionaria, sobre todo para cuestiones complejas y, sí, compras complejas. Imagina a Google capaz de ofrecer diferentes anuncios en cada paso de este viaje hacia una compra.

Desafortunadamente, la mayor amenaza a corto plazo para Google es que las personas y las empresas probablemente usarán ChatGPT para producir grandes cantidades de contenido de baja calidad, costándole tiempo y dinero a Google y, quizás, dando lugar a importantes actualizaciones de algoritmos reactivos. Esto también será un dolor de cabeza grave para los profesionales del marketing, quienes tendrán que actuar ante esas actualizaciones.

Lo que es seguro para el 2023 es que la popularidad de ChatGPT y su accesibilidad al público en general causará una explosión de la inversión (para bien o para mal) y acelerará el desarrollo. Si bien Google no irá a ninguna parte, es posible que el panorama de la búsqueda cambie en formas inesperadas (y ocasionalmente no deseadas) el próximo año.

Texto traducido y adaptado de ChatGPT Won’t Replace Google Search (Yet)

Contáctanos si está interesado en posicionarte orgánicamente en Google. En Capybara SEO podemos ayudarte con diferentes estrategias y herramientas.