Todo lo que debes saber del archivo robots.txt

Un archivo robots.txt es un documento de texto que se encuentra en el directorio raíz de un sitio y que contiene información destinada a los rastreadores para la optimización de motores de búsqueda sobre qué URLs deben rastrearse y cuáles no.

Según el Centro de Ayuda de Google, el objetivo principal del archivo no es impedir que las páginas web se muestren en los resultados de búsqueda, sino limitar el número de peticiones que los robots realizan a los sitios, así como reducir la carga del servidor.

En general, el contenido del archivo robots.txt debe considerarse como una recomendación para los rastreadores de búsqueda. ¿Y cómo acceder a ella? En el siguiente artículo, te mostramos todo lo que debes saber de este documento.

¿Para qué sirve el archivo robots.txt?

La función principal de este documento es impedir el escaneo de páginas y archivos de recursos para que el rastreo sea más eficiente. En la mayoría de los casos, el archivo robots.txt oculta información que no aporta ningún valor a los visitantes del sitio web y no afecta a las clasificaciones en las SERP.

¿Cómo crear un archivo robots.txt y dónde colocarlo?

1. Herramientas para configurar el archivo robots.txt

Dado que el documento tiene una extensión .txt, cualquier editor de texto que soporte la codificación UTF-8 será adecuado. La opción más sencilla es el Bloc de notas (Windows) o TextEdit (Mac). También puedes utilizar una herramienta generadora de robots.txt que creará un archivo robots.txt basado en la información especificada.

2. Título y tamaño del archivo

El nombre del archivo debe tener este formato: robots.txt, sin mayúsculas. Según las directrices de Google, el tamaño permitido es de 500 KiB. Si se supera este límite, el robot de búsqueda procesará parcialmente el documento y no rastreará el sitio web o, por el contrario, escaneará el contenido de un sitio web en su totalidad.

3. Ubicación del archivo

El documento debe estar ubicado en el directorio raíz del alojamiento del sitio web y podrás acceder a él a través de FTP. Antes de realizar cualquier cambio, te recomendamos descargar el archivo robots.txt en su forma original.

Te puede interesar: ¿Qué son los informes de rastreo de Google Search Console y cómo utilizarlos?

Sintaxis y directivas de robots.txt

Ahora veamos a detalle la sintaxis de un archivo robots.txt que consiste en directivas (reglas), parámetros (páginas, archivos, directorios) y caracteres especiales, así como las funciones propias que realizan.

Requisitos generales del contenido de los archivos

- Cada directiva debe empezar en una nueva línea y estar formada según el principio: una línea = una directiva + un parámetro.

- Los nombres de archivos que utilicen alfabetos distintos del latín deben convertirse ser convertidos mediante el conversor Punycode.

- En la sintaxis de los parámetros, debes ceñirte al registro correspondiente. Por ejemplo, si el nombre comienza con una letra mayúscula, nombrarla con una letra minúscula desorientará al robot, viceversa.

- Queda absolutamente prohibido el uso de un espacio al principio de una línea, comillas o punto y coma para las directivas.

- Los motores de búsqueda pueden percibir un archivo robots.txt vacío o inaccesible como un permiso para rastrear todo el sitio. Pero, para que este tenga éxito, es necesario que generes el código de estado de respuesta 200 OK HTTP.

Símbolos

A continuación, analicemos los principales símbolos que contiene el archivo robots.txt y descubramos qué significa cada uno de ellos.

- La barra (/) se añade después del comando, antes del nombre del archivo o directorio (carpeta, sección). Si quieres cerrar todo el directorio, tienes que poner otra «/» después del nombre.

- El asterisco (*) indica que el archivo robots.txt se aplica a todos los robots de los motores de búsqueda que visitan el sitio.

- El signo de dólar ($) es una restricción de tipo asterisco que se aplica a las direcciones URL de los sitios.

- El numeral (#) marca cualquier texto después de ella como un comentario, el cual significa que no será tenido en cuenta por los robots de búsqueda.

Directivas

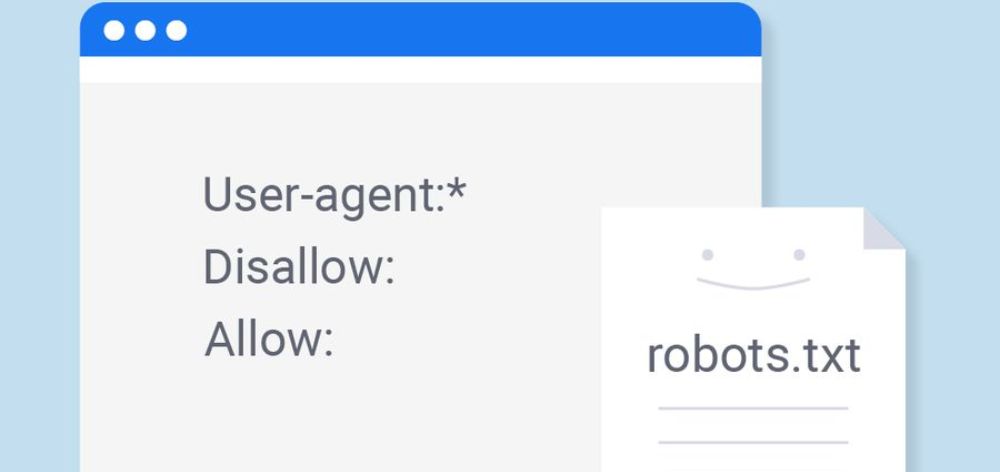

1. Agente de usuario

El agente de usuario es una directiva obligatoria que define el robot de búsqueda y al que se aplican reglas definidas. Si hay varios robots, cada grupo de reglas comienza con esta directiva.

2. Deshabilitar (disallow)

Disallow es un comando clave que indica a los bots de los motores de búsqueda que no analicen una página, archivo o carpeta. Los nombres de los archivos y carpetas a los que se quiere restringir el acceso se indican después del símbolo «/».

3. Habilitar (allow)

En el archivo robots.txt, allow realiza la función opuesta a disallow, permitiendo el acceso al contenido del sitio web. Ambos comandos suelen utilizarse en conjunto, por ejemplo, cuando debes abrir el acceso a una determinada información, como una foto en un directorio de archivos multimedia oculto.

4. Sitemap (mapa de sitio)

Este comando muestra la ruta del mapa de sitio. Pero también puede omitirse si este tiene un nombre estándar, ubicado en el directorio raíz y si es accesible a través del enlace «nombre del sitio»/sitemap.xml.

5. Demora de rastreo

Para evitar la sobrecarga del servidor, se puede indicar a los robots de búsqueda el número de segundos recomendado para procesar una página. Sin embargo, hoy en día los motores de búsqueda rastrean las páginas con un retraso de 1 o 2 segundos.

¿Cómo comprobar tu archivo robots.txt?

A veces, los errores en el archivo robots.txt pueden conducir no solo a la exclusión de páginas importantes del índice, sino a que todo el sitio sea prácticamente invisible para los motores de búsqueda.

La opción de comprobación del archivo robots.txt no aparece en la nueva interfaz de Google Search Console. Ahora podrás comprobar la indexación de las páginas de forma individual (Comprobar URL) o enviar solicitudes de eliminación de URLs (Índice – Eliminaciones).

Hasta aquí, hemos visto todo sobre el archivo robots.txt y cómo indexar tu página web en Google. Esperamos que este artículo te sirva de ayuda a la hora de desarrollar tu página web. No olvides tener en cuenta este archivo, sus directivas y ventajas ¡Sácale provecho al máximo!

Traducido y adaptado de Robots.txt file: What it is, how to set it up, how to check it

Contáctanos si está interesado en posicionarte orgánicamente en Google. En Capybara SEO podemos ayudarte con diferentes estrategias y herramientas.