Los profesionales del posicionamiento web tienen a usar muchas herramientas. Algunas de las más útiles son provistas por los propios buscadores. Los motores de búsqueda quieren que los webmasters creen sitios y contenido accesible, por lo que brindan una variedad de herramientas, datos analíticos y ayuda. Estos recursos gratuitos brindan datos y oportunidades para intercambiar información con los buscadores que no se brindan en ninguna otra parte.

Abajo explicamos los elementos comunes que cada uno de los principales motores de búsqueda apoyan, y explicamos su utilidad.

PROTOCOLOS COMUNES DE LOS BUSCADORES

1. SITEMAPS

Piensa en los sitemaps o mapas de sitio como en una lista de archivos que brindan pistas a los buscadores sobre cómo deben rastrear tu sitio. Los sitemaps ayudan a los motores de búsqueda a encontrar y clasificar contenido en tu web que podrían no haber encontrado por si mismos. Los sitemaps se presentan también en una variedad de formatos, y pueden destacar diferentes tipos de contenidos, entre videos, imágenes, noticias y contenido para móviles.

Puedes ver los detalles completos de este protocolo en Sitemaps.org. Además, puedes construir tu propio sitemap en XML-Sitemaps.com. Los sitemaps se presentan en 3 variedades:

XML

Lenguaje de Marcado Extensible (formato recomendado)

PRO: Es el formato más aceptado para los sitemaps. Es increíblemente fácil de analizar para los buscadores y se puede hacer con una multitud de generadores de sitemaps. Además, permite controlar la totalidad de los parámetros de página.

CONTRA: Archivos relativamente grandes. Debido a que el XML necesita un tag de apertura y otro de cierre para cada uno de los elementos, el tamaño de los archivos puede llegar a ser bastante grande.

RSS

Sindicación Realmente Simple o Resumen Óptimo del Sitio

PRO: Fácil de mantener. Los sitemaps RSS pueden ser codificados para actualizarse automáticamente cuando se añade contenido nuevo.

CONTRA: Más difícil de usar. Aunque el RSS es un dialecto del XML, es en realidad mucho más difícil de usar debido a sus propiedades de actualización.

TXT

Archivo de Texto

PRO: Increíblemente fácil. El formato del sitemap es una URL por línea hasta 50.000 líneas.

CONTRA: No puede añadir meta datos a las páginas.

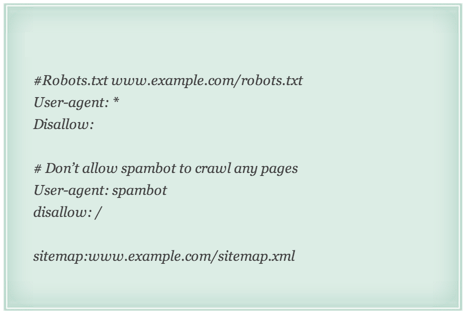

ROBOTS.TXT

El archivo robots.txt (producto del Protocolo de Exclusión de Robots) debería guardarse en el directorio raíz del sitio web (p.ej. www.google.com/robots.txt). El archivo sirve como guía de acceso a los visitantes autómatas (los robots de los buscadores).

Usando robots.txt, los webmasters pueden indicar qué áreas del sitio les gustaría que los robots no rastrearan así como indicar la localización de los archivos de sitemaps (explicados abajo) y los parámetros de la duración de rastreo. Puedes leer más detalles al respecto en la página del Centro de Conocimiento de robots.txt.

Existen los siguientes comandos:

Disallow

No permite que los robots recopiladores accedan a ciertas páginas o carpetas

Sitemap

Indica la ubicación del mapa o mapas del sitio web

Crawl Delay

Indica la velocidad (en milisegundos) a la que el robot puede rastrear un servidor.

Ejemplo de un archivo robots.txt

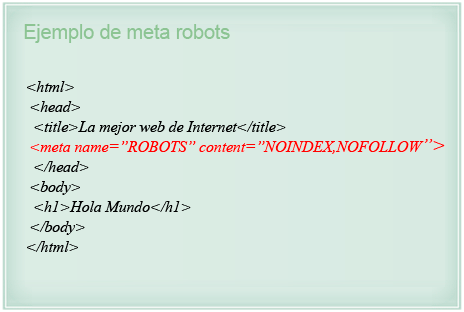

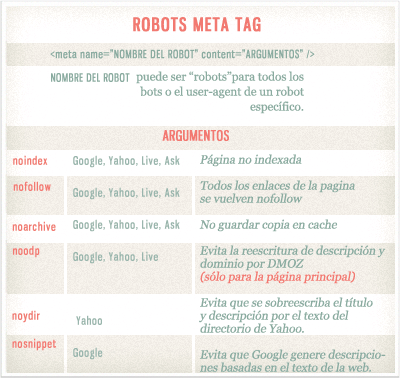

META ROBOTS

El meta tag robots crea instrucciones a nivel de página para los robots de los buscadores.

El meta tag robots debería incluirse en la sección de encabezamiento (head) del documento HTML.

REL=»NOFOLLOW»

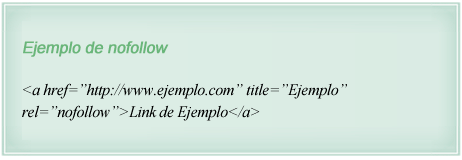

¿Recuerdas que los enlaces actúan como votos? El atributo rel=»nofollow» te permite enlazar a un recurso, almismo tiempo eliminando tu «voto» en cuanto al posicionamiento se refiere. Literalmente, «nofollow» le dice a los buscadores que no sigan el enlace, aunque algunos motores los siguen de todos modos para descubrir nuevas páginas. Estos enlaces de seguro pasan menos valor (o ningún valor) que los enlaces sin el atributo, pero existen muchas situaciones en los que son útiles, como cuando se enlaza a una web poco confiable.

REL=»CANONICAL»

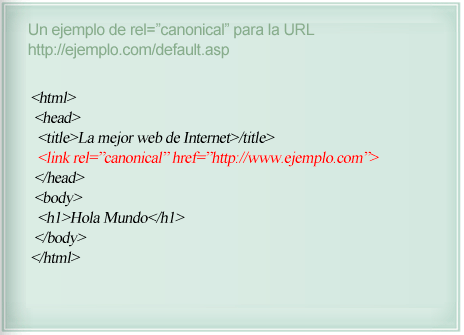

Con frecuencia, dos o más copias de exactamente el mismo contenido aparecen en tu página web bajo URLs diferentes. Por ejemplo, las siguientes URLs pueden todas referirse a la misma página inicial de un sitio:

– http://www.ejemplo.com/

– http://www.ejemplo.com/default.asp

– http://ejemplo.com/

– http://ejemplo.com/default.asp

– http://Ejemplo.com/Default.asp

Para los buscadores, estas son 5 páginas distintas. Dado que el contenido en cada una es idéntico, esto puede causar que los buscadores disminuyan el valor del contenido, así como su capacidad de obtener rankings.

El tag canonical resuelve este problema indicándole a los robots de búsquedas que página es la principal entre todas estas versiones, la que debería contar en los resultados de búsqueda.

En el ejemplo superior, rel=canonical le indica a los robots que esta página es una copia de http://www.ejemplo.com, y que debe considerarse esta última URL como la URL canónica.

HERRAMIENTAS DE LOS BUSCADORES

HERRAMIENTAS PARA WEBMASTERS DE GOOGLE – CARACTERÍSTICAS POPULARES

Herramientas para Webmasters de Google

CONFIGURACIÓN DEL SITIO

Orientación Geográfica – Si una web esta orientada a usuarios en una ubicación geográfica en particular, los webmasters pueden brindar a Google información que le ayudará a determinar la forma en que dicha web aparece en los resultados de búsqueda de un determinado país, así como mejorar los resultados de Google para búsquedas geográficas.

Dominio Preferido – El dominio preferido es aquel que los webmasters prefieren usar para que se indexen las páginas de su sitio. Si un webmaster especifica su página preferida como http://www.ejemplo.com y Google encuentra un enlace a dicho sitio con el formato http://ejemplo.com, entonces Google tratará dicho enlace como si estuviera apuntando a http://www.ejemplo.com.

Parámetros de URL – Puedes brindar a Google información sobre cada parámetro de tu web, como «ordenar=precio» y «idsesion=2». Esto ayuda a Google a rastrear tu sitio de forma más eficiente. ignorando parámetros que producen contenido duplicado e incrementando el número de páginas únicas que Google rastreará en tu sitio.

Frecuencia de RastreoLa frecuencia de rastreo afecta la velocidad de las solicitudes del bot de Google durante el proceso de rastreo. No tiene efecto alguno en la forma como Google rastrea una web en particular. Google determina la frecuencia recomendada de acuerdo al número de páginas del sitio.

DIAGNÓSTICO

Software malintencionado – Google te informará si ha encontrado software malintencionado en tu web. El malware no solo es malo para los usuarios, sino que también representa un efecto negativo en tus rankings.

Errores de rastreo – Si el bot de Google encuentra una cantidad significativa de errores mientras rastrea tu web, como los errores 404, los reportará e identificará en dónde encontró el enlace que lo llevó a la URL inaccesible.

Sugerencias de HTML – Este análisis identifica elementos HTML que no son amigables con los buscadores. Específicamente, aquí se listan problemas con las meta descripciones, títulos y contenido no indexable.

TRÁFICO DE BÚSQUEDA

Estas estadísticas ofrecen indicadores útiles para los SEOs, ya que reportan las impresiones por keywords, rangos de clics, las páginas más populares en los resultados de búsqueda, y estadísticas de enlaces. De todas formas hay que tener cuidado, pues muchos SEOs reportan que los datos que se brindan en esta sección son incompletos y que sólo ofrece datos estimados.

RASTREO

Esta importante sección te permite enviar sitemaps, probar archivos robots.txt, mejorar sitelinks, y enviar solicitudes de eliminación de URLs al índice de Google.

LABS

La sección Labs de las Herramientas para Webmasters de Google contiene reportes que Google considera en estado experimental, pero que aún así pueden ser importantes para los webmasters.

CENTRO PARA WEBMASTERS DE BING

Centro para Webmasters de Bing

PRINCIPALES CARACTERÍSTICAS

Resumen de sitios – Esta interfaz brinda un resumen del rendimiento de todas tus webs en los resultados de búsqueda de Bing. Las métricas que incluye son clics, impresiones, páginas indexadas y número de páginas rastreadas por cada sitio.

Estado de rastreo – Aquí puedes ver reportes de cuantas páginas de tu sitio ha rastreado Bing, y cuantos errores ha descubierto. Al igual que en las herramientas de Google, puedes enviar sitemaps para ayudar a Bing a descubrir y priorizar tu contenido.

Indexación – Esta sección permite al webmaster ver y ayudar a controlar la forma en que Bing indexa las páginas. Al igual que en Google Webmaster Tools, aquí puedes explorar cómo se encuentra organizado tu contenido en Bing, enviar URLs, eliminar URLs de los resultados de búsqueda, analizar los enlaces entrantes y ajustar la configuración de parámetros.

Tráfico – El resumen de tráfico en Bing reporta las impresiones y clics mediante una combinación de resultados de Bing y Yahoo. Los reportes aquí muestran posiciones promedio así como estimados de costos en caso decidas comprar anuncios para dichas keywords.

Aunque no forma parte de ningún buscador, el servicio Open Site Explorer de Moz brinda datos similares.

CARACTERÍSTICAS

Identificar enlaces de alto valor – Open Site Explorer organiza todos tus enlaces entrantes de acuerdo a sus métricas, las cuales te ayudan a determinar cuáles enlaces son los más importantes.

Encuentra los dominios más fuertes enlazándote – Esta herramienta te muestra los dominios de mayor valor que enlazan a tu dominio.

Analizar la distribución de los textos ancla – Open Site Explorer te muestra la distribución de los textos que usan las personas para enlazarte.

Comparación cara a cara – Esta característica te permite comparar dos webs para ver cuál tiene mayor valor.

Métricas Sociales – Mide las veces que se comparten tus contenidos en Facebook, los Me Gusta, los tweets, +1’s para cualquier URL.